Ética y robots

Según una curiosa noticia publicada recientemente en EL PAÍS, el gobierno de Corea del Norte está preparando un código ético que regulará la relación entre robots y seres humanos. Cada vez las máquinas son más autónomas y pueden actuar con mayor independencia respecto a los seres humanos, tomando decisiones que nos afectan. Sin ir más lejos, mi coche ya toma muchas decisiones por mí: enciende los faros cuando detecta oscuridad, activa los limpiaparabrisas cuando llueve y regula su ritmo según la intensidad de la lluvia, cuando detecta cierto tipo de frenada brusca activa un mecanismo que impide que el coche derrape y lo detiene completamente, aunque deje de frenar, etc... Pero además

Según una curiosa noticia publicada recientemente en EL PAÍS, el gobierno de Corea del Norte está preparando un código ético que regulará la relación entre robots y seres humanos. Cada vez las máquinas son más autónomas y pueden actuar con mayor independencia respecto a los seres humanos, tomando decisiones que nos afectan. Sin ir más lejos, mi coche ya toma muchas decisiones por mí: enciende los faros cuando detecta oscuridad, activa los limpiaparabrisas cuando llueve y regula su ritmo según la intensidad de la lluvia, cuando detecta cierto tipo de frenada brusca activa un mecanismo que impide que el coche derrape y lo detiene completamente, aunque deje de frenar, etc... Pero además oímos en las noticias que ya están fabricando coches que son capaces, incluso, de tomar decisiones respecto a la misma conducción del coche (por ejemplo, frenar cuando detecta que está muy cerca de otro coche con riesgo de colisión o cuando nos dormimos al volante).

oímos en las noticias que ya están fabricando coches que son capaces, incluso, de tomar decisiones respecto a la misma conducción del coche (por ejemplo, frenar cuando detecta que está muy cerca de otro coche con riesgo de colisión o cuando nos dormimos al volante).

Estas máquinas, cada vez más capaces de decidir por nosotros, están ya presentes en todos los ámbitos de la vida diaria y todo parece indicar que esta presencia se intensificará. Quizás un día nos atienda un robot cirujano, o le encarguemos a un programa de ordenador que busque el mejor colegio para nuestros hijos por internet. Estas tareas implican tomar decisiones complejas y dadas las consecuencias que de ellas pueden derivarse, exigen responsabilidad. Este es el motivo por el cual el gobierno de Corea del Norte piensa que es necesario un código ético para los robots.

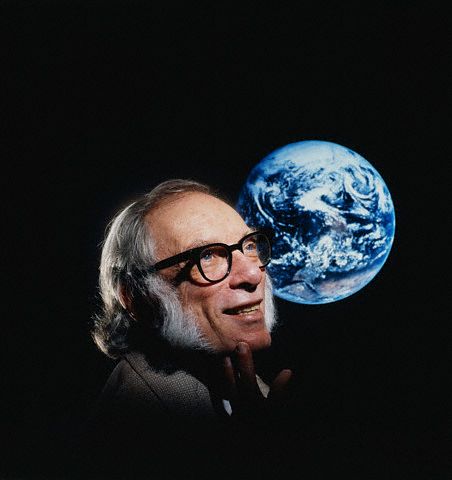

Este código se basará en las famosas leyes de la robotica de Asimov:

- Un robot no puede hacer daño a un ser humano o, por inacción, permitir que un ser humano sufra daño.

- Un robot debe obedecer las órdenes dadas por los seres humanos, excepto si estas órdenes entrasen en conflicto con la Primera Ley.

- Un robot debe proteger su propia existencia en la medida en que esta protección no entre en conflicto con la Primera o la Segunda Ley

Otra cosa es lo que, al parecer, vaticina cierto estudio del gobierno británico, según el cual, dentro de unos 50 años, los robots reclamarán derechos humanos. El debate sobre la ampliación de los derechos humanos a otras especies ya ha comenzado hace tiempo, con el PROYECTO GRAN SIMIO, que pretende dotar a los grandes simios de ciertos derechos. Lo que se plantea aquí es más radical: ampliar los derechos humanos a ciertas máquinas. Según los defensores del proyecto gran simio, es la conciencia de sí lo que justifica que un ser vivo goce de derechos (otros teóricos son menos estrictos y sólo exigen estar vivo para poder tener derechos).

Se ha demostrado que ciertos simios tienen una conciencia de sí mismos suficiente como para plantear el problema de sus derechos con sentido. Pero ¿Puede una máquina llegar a ser consciente de sí misma? ¿Si así fuera, tendría derechos? En caso afirmativo, no se trataría de obligar a los fabricantes a construir sus máquinas de un modo determinado, sino que serían las propias máquinas las que gozarían de derechos y, por lo tanto, de obligaciones propias y genuinas. Esto es muy distinto de las leyes de Asimov.

Creo que aquí nos encontramos ante un genuino problema filosófico e independientemente de que la construcción de robots 'humanos' sea o no posible, de lo que se está hablando es no sólo de la naturaleza de la moral, sino de algo más profundo: qué nos hace humanos.

Links:

Links:Inteligencia Artificial (Artículo de la Wikipedia)

Daniel Dennet (Uno de los filósofos más importantes dedicado al estudio de la conciencia y la inteligencia artificial)

Roger Penrose (Físico interesado en los fundamentos cuánticos de la conciencia, crítico de la inteligencia artificial)

Web 3.0 (Es el nuevo modelo de web que viene, también llamada web semántica, se trataría de una especie de 'internet inteligente')